Spark-sql 跟hive

|

|

- 采用动态设置metastore_uris本来想动态地链接hive的,但是每次这么设置后并不奏效,按理说代码中对配置信息进行设置的优先级要高于配置文件的,但实际上并非如此。初步揣测,spark在启动的时候已经连接上hive 了。但是下面的两种方式都是可以动态连接hive的。

|

|

Spark-sql 跟mysql

|

|

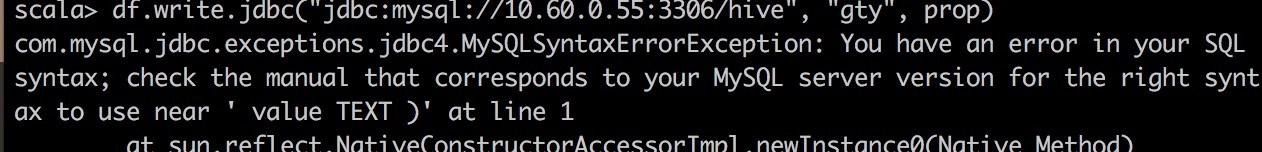

- 刚开始测试的一个json文件中,有两列,名字分别是key跟value,结果执行的时候报出一个错误:

- 这个应该是一个sql语法的问题,单单从程序上看,这里根本没有什么SQL语句。细究以后会发现spark-sql会利用dataframe中的schema信息去创建一个表格,所以内部的逻辑会有一个创建表格的sql语句,其中出现value是因为schema中有value,所以当我将json文件中的schema信息中的value替换掉就OK了。大胆猜测value应该是sql的保留字之类的。

进一步的工作

hive的动态连接还存在一定问题,这主要是对hive缺乏必要的了解导致的,接下来会看看spark-sql跟hive是怎么整合的,把这个问题给解决掉。